販売終了となりました。長年のご愛顧ありがとうございました。

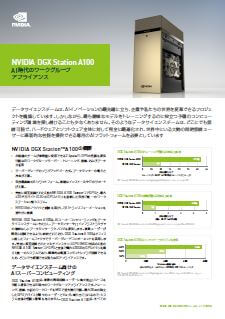

DGX STATION A100 ラインナップ・160GBモデル(NVIDIA A100 Tensor Core GPU 40GB × 4 基搭載)

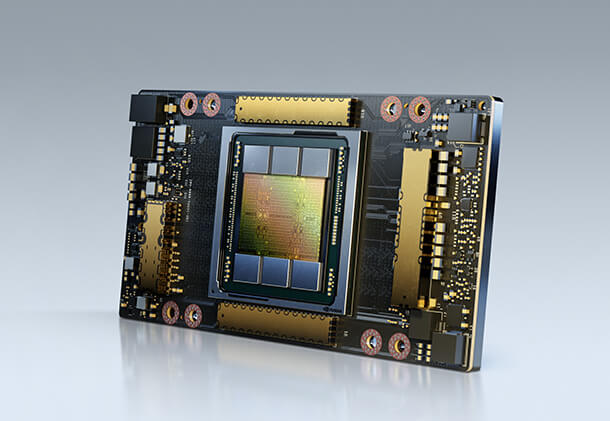

・320GBモデル(NVIDIA A100 Tensor Core GPU 80GB × 4 基搭載) NVIDIA A100 Tensor Core GPUを搭載したモデルがリリースされました。

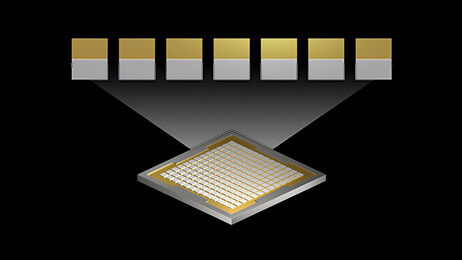

DGX STATION A100は、デスクサイドに設置可能なワークステーションサイズです。 静音に優れ、データ センターの電力と冷却機能を必要としない AI システム。 CPUにAMD 64Core EPYCを搭載。NVIDIA A100 GPU が 4 つ完全相互接続されています。各GPU間は200GB/Secの第三世代NVLinkで接続されており、Gen4のPCI-Expressと比較して3倍のバンド幅を実現。 DGX Station A100 は、オフィス内や研究室など、どこにでも設置でき、データセンター並みのパフォーマンスを発揮します。 |

DGX STATION A100 特徴

NVIDIA A100 Tensor Core GPU を搭載した初のワークステーション

新しい冷却システム ポンプ冷却による2段階冷却

|

|

職場や自宅にデータセンターのパフォーマンスをもたらします

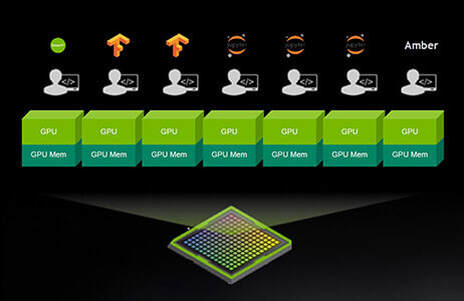

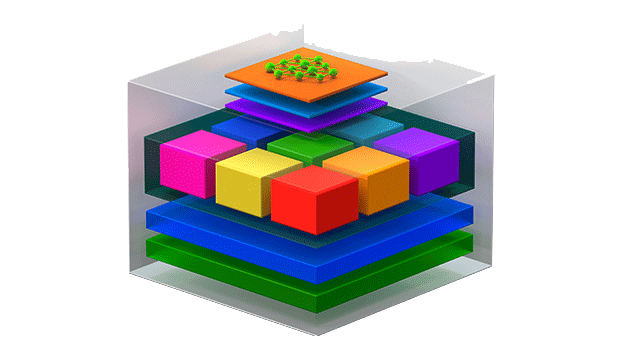

あらゆるワークロードに対応DGX Station A100 を利用すれば、組織は、NVIDIA DGX™ ベースの他のインフラストラクチャとシームレスに統合されたシステムを利用し、あらゆるワークロード (トレーニング、推論、データ分析) のために、集中型 AI リソースを複数のユーザーに提供できます。

また、マルチインスタンス GPU (MIG) を利用すると、最大 28 台の独立した GPU デバイスを個々のユーザーに割り当てることができます。 |

データセンターと同等のパフォーマンスDGX Station A100 は、サーバー級ながら、データ センターの電力と冷却機能を必要としない AI システムです。

DGX Station A100 は 4 つの NVIDIA A100 Tensor コア GPU、最上位のサーバー級 CPU、超高速 NVMe ストレージ、最先端の PCIe Gen4 バスを備えています。それに加えてリモート管理が可能で、サーバーのように管理できます。 |

どこにでも

|

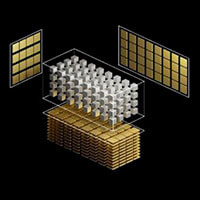

より大規模なモデル、より高速な応答NVIDIA DGX Station A100 は、MIG 対応 NVIDIA A100 GPU が 4 つ完全相互接続された、世界で唯一のワークステーションスタイル システムです。NVIDIA® NVLink® によって、システム パフォーマンスに影響を与えることなく、並列ジョブを実行し、複数のユーザーに対処します。

完全に GPU 最適化されたソフトウェア スタックと最大 320 ギガバイト (GB) の GPU メモリで大規模モデルをトレーニングできます。 |

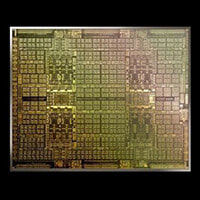

搭載GPU

NVIDIA A100 Tensor Core 特徴

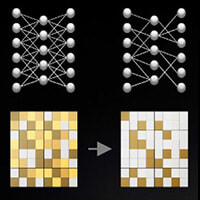

新たなマルチインスタンス GPU (MIG)とは・・・GPU を利用できるユーザーが増える

MIG を利用すれば、1 つの A100 GPU で GPU リソースを最大 7 倍にすることができます。MIG があれば、研究者や開発者はこれまでにない多くのリソースと柔軟性を得られます。 GPU 利用率を最適化する MIG には、さまざまなインスタンス サイズを選択できる柔軟性があり、各ワークロードに適した規模で GPU をプロビジョニングできます。結果的に、利用率が最適化され、データ センターに対する投資が最大化されます。 混合ワークロードを同時実行する MIG を使用すると、推論、トレーニング、ハイ パフォーマンス コンピューティング (HPC) といった複数のワークロードを、互いのレイテンシとスループットに影響を与えることなく単一 GPU 上で同時に実行できます。 |