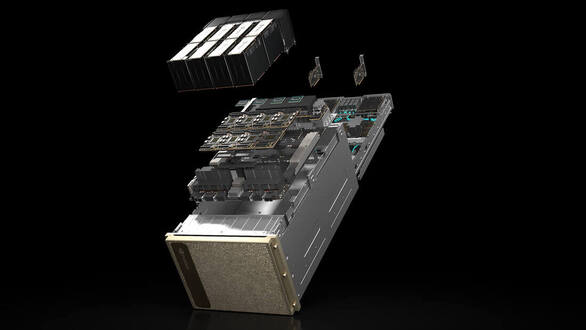

NVDIA H100 GPU 8基 搭載

NVIDIA DGX H100 受注開始!

2022年3月に、GPUの新アーキテクチャ Hopper採用の「NVIDIA H100 Tensor コア GPU」がNVIDIAより発表され、その「NVIDIA H100 GPU」が8基搭載された「NVIDIA DGX H100」も同時に発表されました。

G-DEPでは「NVIDIA DGX H100」の受注を開始しました。

G-DEPでは「NVIDIA DGX H100」の受注を開始しました。

NVIDIA DGX H100 特徴

|

NVIDIA DGX H100は、DGXシステムの第 4 世代となり、新しい NVIDIA AI ソフトウェア ソリューションに対応し、多様なサードパーティのサポートを受けられるエコシステムが利用可能で、NVIDIA プロフェッショナル サービスによりエキスパートからのアドバイスを受けることができます。

NVIDIA DGX H100 は、6 倍高速なパフォーマンス、2 倍高速なネットワーキング、およびハイスピードなスケーラビリティを NVIDIA DGX SuperPOD に対しても発揮します。この次世代アーキテクチャHopperは、自然言語処理やディープラーニングによるレコメンデーション モデルといった大規模なワークロードに対応できるように強化されています。 NVIDIA DGX H100 は、オンプレミスにインストールして直接管理したり、NVIDIA DGX 対応のデータ センターでの設置や、NVIDIA DGX Foundry でのレンタル、NVIDIA 認定のマネージド サービス プロバイダーを通じてアクセスすることもできます。 |

■ NVIDIA H100 Tensor Core GPU × 8GPU

|

■ NVIDIA NVSWITCHES™ × 4

|

■ NVIDIA CONNECTX®-7 × 8

NVIDIA BLUEFIELD® DPU 400Gb/秒 ネットワーク インターフェイス × 2

- ピーク時の双方向ネットワーク帯域幅:1 TB/秒

■ デュアル x86 CPU と 2TB システムメモリ

|

■ 30TB NVME SSD

|

NVIDIA DGX H100 スペック

GPU |

NVIDIA H100 Tensor コア GPU [80GB] × 8基 |

GPUメモリ |

合計 640GB |

性能 |

32 petaFLOPS /FP8 |

NVIDIA® NVSwitch™ |

× 4 |

CPU |

デュアル ×86 |

システムメモリ |

2TB |

ネットワーキング |

4個のOSFPポート 8基のシングルポート ConnectX-7 へ接続 400Gb/秒 InfiniBand/Ethernet 2基のデュアルポート NVIDIA BlueField-3 DPU VPI 400Gb/秒 InfiniBand/Ethernet × 1 200Gb/秒 InfiniBand/Ethernet × 1 |

管理ネットワーク |

100Gb/秒 オンボード NIC(RJ45付き) 50Gb/秒 Ethernet オプション NIC ホスト ベースボード管理コントローラー(BMC)(RJ45付き) NVIDIA BlueField-3 DPU BMC × 2(それぞれRJ45コネクタで接続) |

ストレージ |

OS:1.9TB NVMe M.2 × 2 内部ストレージ:3.84TB NVMe U.2 × 8 |

システムソフトウエア |

DGX H100システムにプレインストールされている DGX OSは、Ubuntu Linux をベースとし、DGXソフトウェア スタック(DGX用に最適化されている必要なすべてのパッケージとドライバー)が含まれています。 オプションで、お客様がUbuntu Linux または、Red Hat Enterprise Linux、および必要なDGXソフトウェア スタックを個別にインストールすることもできます。 |

動作温度範囲 |

5 °C ~ 30 °C |

最大消費電力 |

10.2 kW |